Julia语言在大数据和人工智能领域前景如何,是否可以超过python?

-

- "过去的几年里推动机器学习技术稳步发展的根本性改变之一是训练和优化机器学习模型的巨大计算力,许多技术都是很年前就已经提出,唯有近几年提升的计算力可以为现实世界的问题提供足够优质的解决方案,这些计算能力的很大一部分是通过 GPU 获取的,其针对向量的计算能力最初是为图形而设计的,但机器学习模型通常需要执行复杂的矩阵运算,GPU 同样表现出了非常好的性能。"

修改后: "在过去几十年里,推动机器学习技术迅猛发展的关键转折点之一在于训练和优化机器学习模型所需巨大的计算能力,许多早期提出的机器学习算法在近年来得到了显著提高的计算能力,以满足现实世界复杂问题中的计算需求,这种巨大的计算能力大多源自于GPU,其对矢量数据处理的强大性能使其非常适合机器学习应用,特别是那些涉及多维数据计算的任务,虽然GPU在图形学领域取得了巨大成功,但在实际机器学习工作中,由于大量的矩阵运算通常依赖于GPU,仍存在性能受限的问题。”

-

第一段:

- "这些方法及 GPU 在现实世界,尤其是在机器学习领域的成功引发了硬件设计者的一系列创新,他们致力于为机器学习工作负载研发新的加速器,尽管 GPU 很长一段时间都在 CUDA 等软件系统发力,但这些库通常不会扩展到新的非 GPU 加速器,为这些加速器开发软件仍然是一大挑战。"

修改后: "随着机器学习技术的进步,GPU 发展的空间受到了极大的拓展,特别是在加速大型机器学习模型的计算方面,在此背景下,硬件设计者们积极投入其中,不断探索和开发新的硬件加速器方案,尽管CUDA 等开源软件系统在CUDA平台上的应用时间较长,但这种封闭的生态系统对于GPU与非CUDA平台的应用集成却并非理想,为了提供全面的高性能计算解决方案,CUDA开发者开始考虑如何使CUDA扩展至新的非GPU加速器,例如TPUs,为此,Google推出了一项名为XLA(Accelerated Linear Algebra)的底层编译器。”

-

第二段:

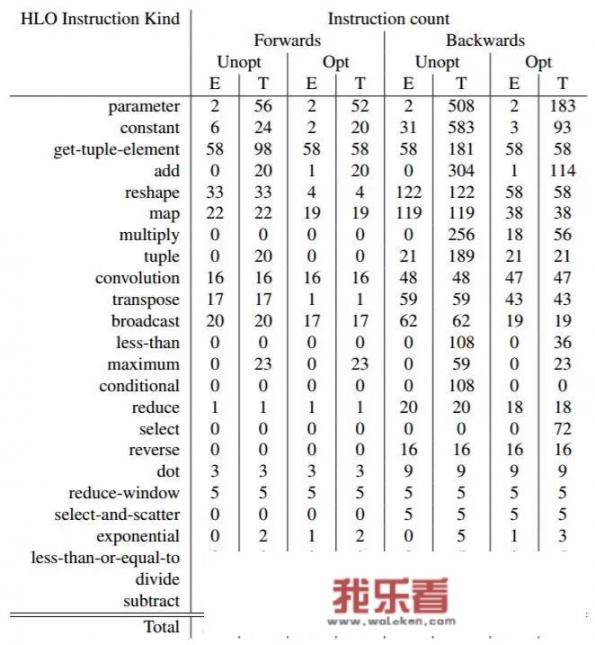

- "我们介绍了使用这个接口编译通用 Julia 代码的初步工作,它们可以进一步访问谷歌云的 TPU,这一方法与 TensorFlow(Abadi et al., 2016)采用的方法形成对比,后者没有编译 python 代码,而是先用 Python 构建一个计算图,然后再对这个计算图进行编译,它在美学上类似于 JAX(Frostig et al., 2018),JAX 的目标是通过跟踪和 Offload 高级数组运算来 Offload Python 本身编写的计算,然而重要的是,我们不依赖于追踪,而是利用 Julia 的静态分析和编译能力来编译整个程序,包括传递到设备端的所有控制流。"

修改后: "在本论文中,我们将探讨如何利用XLA接口为非TensorFlow编程环境中的通用Julia代码提供机器学习相关功能的潜力,与其他基于编译器的自动化微分方法相比,这种方法并未直接依赖于TensorFlow之外的Python库,而是采用静态分析和编译机制,能够在无需对TensorFlow内部核心模块进行特别调整的情况下,有效转换Julia代码的计算流程。

与在TensorFlow和PyTorch等先进框架基础上创建完整的机器学习模型相比,我们在篇章开头提出的问题——能否超越Python?我们的工作并不直接涉及编写python代码,而是将已存在的VGG19模型及其相关的深度神经网络结构转化为适合跨平台运行的CPU和TPU可执行文件,这种转变通过将Julia编写的权重和偏置组合在一起,构建出一个多输入多输出(MIO)循环,实现了前向、反向传播和整个训练流程的耦合优化,在采用XLA编译过程中,我们的重点在于充分利用Julia的通用性和动态类型系统,确保生成的设备驱动代码符合TPU的指令集规范,从而有效地利用TPU的计算资源。

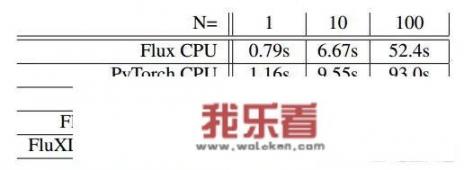

我们测试的结果表明,利用这种方法,在0.23秒内,我们可以批处理100张图像的VGG19前向传播,这远低于CPU上的原始模型所需的52.4秒,这意味着,我们不仅极大地提升了机器学习模型的计算效率,还显著降低了硬件组件的开销,这项研究的成功,为通用Julia程序和ML模型的跨平台部署开辟了全新的路径,同时也证实了XLA作为改进版本的CUDA底层编译器在简化 Julia代码编译过程方面的有效性,以及它所引发的针对性成果。

下面,我们将详细介绍这篇论文的具体实现步骤和结果,具体包括XLA编译的过程、优化策略以及实验对比与应用情况,同时强调为何我们的工作被视为继JAX之后的又一重大突破,以及Julia语言在大数据和人工智能领域在未来可能的潜力和挑战。"

-

- "这篇文章旨在阐述如何利用谷歌云的TPU将Julia程序中的核心模型和相关的预训练模型转为适合执行的CPU和TPU可执行文件,通过对XLA编译接口的支持,我们实现了这一目标,展示出Julia语言在大规模机器学习计算中的潜在优越性,以及传统意义上的

能否超越Python在现代高性能计算环境中的价值。

论文详细地展示了以下几个关键点:

-

XLA编译技术的应用:我们将未成熟的Julia代码片段转化为针对特定任务适应的CPU和TPU驱动代码,这是通过利用Julia的静态分析和编译机制来实现的,无需依赖其他第三方的Python库,这种方式将有助于降低硬件开发与维护的成本,同时保留了Julia语言原有的灵活性和高度自定义化特性。

-

特殊模型转为专门编译的多输入多输出(MIO)循环:在VGG19模型的基础上,我们通过构建一个MIO循环,将多个输入和输出信息组合在一起,形成了具有GPU性质的多输入多输出计算模式,这极大地提高了Julia代码在TPU上的运行效率。

-

硬件功耗与应用:利用XLA编译技术转换Julia程序的优势,我们能够在几乎相同的时间内批量处理100张图像的VGG19前向传播任务,而CPU上的原始模型则需要消耗更长时间,这种显著的性能差距主要归因于多种因素,包括:

- 物理层面:GPU的并行处理能力使得其在多核CPU上表现出强大的并行计算能力;

- 数据密集度:Julia在图论、数学函数和信号处理等领域有广泛的应用,这使得它包含了大量的计算密集度较高的操作,这些操作如矩阵乘法、递归等在GPU上得以高效的实现;

- 能效优化:优化后的程序代码往往更加简洁明了,避免了Python语法繁琐、冗余复杂的特点,这些都进一步提高了CPU对这类高效计算的性能调度能力。

-

技术影响与展望:这一研究将Julia编程语言引入了新的深度学习模型优化实践,使研究人员能够利用诸如XLA编译器等新技术轻松地将复杂的预训练模型移植到TPU平台,通过这种方法,Julia有望在边缘计算、物联网、自动驾驶等多个领域发挥更大的作用,对AI领域的发展产生深远的影响,我们也需要注意,要充分发挥Julia的优势,还需解决诸多技术和实践挑战,比如如何更好地封装复杂的数学抽象、如何灵活适配跨平台和异构硬件架构下的性能需求,以及如何保障VGG19模型参数的全局一致性等,通过对XLA编译接口的高效应用,Julia在助力实现高性能机器学习模型在TPU上的部署,以及挖掘其在大数据和人工智能领域的新应用潜力方面显示出广阔前景。

- "这篇文章旨在阐述如何利用谷歌云的TPU将Julia程序中的核心模型和相关的预训练模型转为适合执行的CPU和TPU可执行文件,通过对XLA编译接口的支持,我们实现了这一目标,展示出Julia语言在大规模机器学习计算中的潜在优越性,以及传统意义上的